Różnica między MapReduce i Spark

- 4067

- 862

- Patrycy Ziółkowski

Apache Spark jest jednym z najbardziej aktywnych projektów typu open source w ekosystemie Hadoop i jedna z najgorętszych technologii w analizie Big Data dzisiaj. Zarówno MapReduce, jak i Spark są ramami open source do przetwarzania dużych zbiorów danych. Jednak Spark jest znany z przetwarzania w pamięci i jest idealny do przypadków, w których dane pasują do pamięci, szczególnie w dedykowanych klastrach. Porównujemy dwa wiodące ramy oprogramowania, aby pomóc Ci zdecydować, które jest dla Ciebie odpowiednie.

Co to jest MapReduce?

MapReduce to model programowania w ramach Hadoop dla obliczeń rozproszonych na podstawie Java. Służy do dostępu do dużych zbiorów danych w systemie plików Hadoop (HDFS). Jest to sposób na strukturyzację obliczeń, który pozwala na łatwe prowadzenie na wielu maszynach. Umożliwia masywną skalowalność na setkach lub tysięcy serwerów w klastrze Hadoop. Umożliwia pisanie rozproszonych, skalowalnych zadań przy niewielkim wysiłku. Służy dwie podstawowe funkcje: filtruje i rozpowszechnia prace do różnych węzłów w klastrze lub mapie. Służy do analizy danych na dużą skalę przy użyciu wielu maszyn w klastrze. Framework MapReduce to zazwyczaj trzyetapowy proces: mapa, tasowanie i zmniejszenie.

Co to jest Apache Spark?

Spark to open source, super szybka framework Big Data, powszechnie uważany za następcę mapreduce do przetwarzania dużych zbiorów danych. Spark to ulepszenie Hadoop do MapReduce używane do obciążeń dużych zbiorów danych. Dla organizacji, która do analizy ma ogromne ilości danych, oferuje szybki i łatwy sposób analizy danych w całym klastrze komputerów. Jest to wielojęzyczny ujednolicony silnik analityczny dla dużych zbiorów danych i uczenia maszynowego. Jego ujednolicony model programowania sprawia, że jest to najlepszy wybór dla programistów budujących bogate w dane aplikacje analityczne. Zaczęło się w 2009 roku jako projekt badawczy w UC Berkley's Amplab, wspólny wysiłek z udziałem studentów, badaczy i wykładowców.

Różnica między MapReduce i Spark

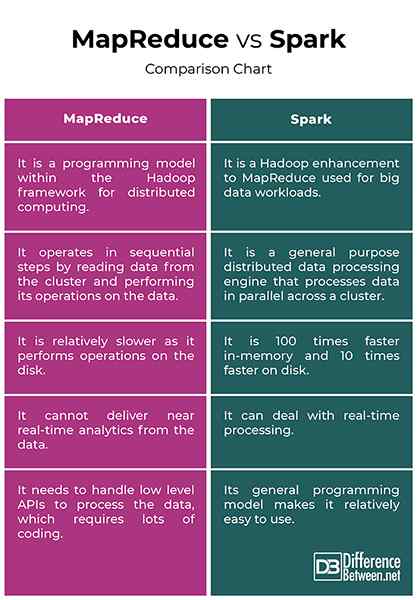

Przetwarzanie danych

- Hadoop przetwarza dane w partiach, a MapReduce działa w sekwencyjnych krokach, odczytując dane z klastra i wykonywanie jego operacji na danych. Wyniki są następnie zapisywane z powrotem do klastra. Jest to skuteczny sposób przetwarzania dużych, statycznych zestawów danych. Z drugiej strony Spark to rozdzielony silnik przetwarzania danych ogólnego przeznaczenia, który przetwarza dane równolegle w klastrze. Wykonuje przetwarzanie danych w czasie rzeczywistym i wykresu.

Wydajność

- Hadoop MapReduce jest stosunkowo wolniej. Z drugiej strony Spark jest zaprojektowany w taki sposób, że przekształca dane w pamięci, a nie na we/wy, co z kolei skraca czas przetwarzania. Spark jest w rzeczywistości 100 razy szybszy w pamięci i 10 razy szybciej na dysku. W przeciwieństwie do MapReduce, może poradzić sobie z przetwarzaniem w czasie rzeczywistym.

Koszt

- Hadoop działa po niższych kosztach, ponieważ jest oprogramowaniem typu open source i wymaga więcej pamięci na dysku, który jest stosunkowo niedrogim towarem. Spark wymaga więcej pamięci RAM, co oznacza, że konfigurowanie klastrów iskier może być droższe. Ponadto Spark jest stosunkowo nowi, więc eksperci w Spark są rzadkimi znaleziskami i bardziej kosztownymi.

Tolerancja błędów

- MapReduce jest ściśle oparty na dysku oznacza, że wykorzystuje trwałe przechowywanie. Podczas gdy oba zapewniają pewien poziom niepowodzeń obsługi, tolerancja błędów Spark opiera się głównie na operacjach RDD (Resilient rozproszonych zestawów danych. RDD to element składowy Apache Spark. Hadoop jest naturalnie odporny na uszkodzenia, ponieważ jest zaprojektowany do replikacji danych w kilku węzłach.

Łatwość użycia

- MapReduce nie ma trybu interaktywnego i jest dość złożone. Musi obsłużyć interfejsy API niskiego poziomu w celu przetwarzania danych, które wymagają dużo kodowania, a kodowanie wymaga wiedzy o zaangażowanych strukturach danych. Spark jest zaprojektowany od dołu w celu uzyskania wydajności i łatwości użytkowania, który pochodzi z ogólnego modelu programowania. Również równoległe programy wyglądają bardzo podobnie do programów sekwencyjnych, co ułatwia ich opracowanie.

MapReduce vs. Spark: Mapa porównawcza

Streszczenie

Główną różnicą między tymi dwoma frameworkami jest to, że MapReduce Processes Dane na dysku, podczas gdy iskrzy przetwarza i zachowuje dane w pamięci dla kolejnych kroków. W rezultacie Spark jest 100 razy szybszy w pamięci i 10 razy szybszy na dysku niż MapReduce. Hadoop używa MapReduce do przetwarzania danych, podczas gdy Spark wykorzystuje odporne rozproszone zestawy danych (RDDS). Spark to ulepszenie MapReduce do przetwarzania dużych zbiorów danych. Podczas gdy MapReduce jest nadal używany do analizy danych na dużą skalę, Spark stał się frameworkiem przetwarzania w środowiskach Hadoop.

Dlaczego iskra jest szybsza niż MapReduce?

Spark procesów i zachowuje dane w pamięci dla kolejnych kroków, co sprawia, że 100 razy szybciej dla danych w pamięci RAM i do 10 razy szybciej dla danych w pamięci. Jego RDD umożliwia wiele operacji map w pamięci, podczas gdy MapReduce musi zapisać wyniki tymczasowe na dysku.

Jakie są różnice między iskrą a nazwą MapReduce co najmniej dwa punkty?

Po pierwsze, MapReduce nie może dostarczyć analizy w czasie rzeczywistym z danych, podczas gdy Spark może poradzić sobie z przetwarzaniem danych w czasie rzeczywistym. A po drugie, MapReduce działa w krokach sekwencyjnych, podczas gdy Spark przetwarza dane równolegle w klastrze.

Jest iskra bardziej zaawansowana niż MapReduce?

Spark jest powszechnie uważany za następcę ramy MapReduce do przetwarzania dużych zbiorów danych. W rzeczywistości Spark jest jednym z najbardziej aktywnych projektów typu open source w ekosystemie Hadoop i jedną z najgorętszych technologii w analizie Big Data.

Czy Spark potrzebuje MapReduce?

Spark nie używa ani nie potrzebuje MapReduce, ale tylko pomysł, a nie dokładna wdrożenie.

- « Różnica między stronniczością uczenia maszynowego a wariancją

- Różnica między mastthead a platformą ułamkową »